科研工作者的 AI 使用指南

以下内容以 Macbook 为演示,Windows 电脑操作可能略有不同,但使用逻辑完全一样。点击链接观看视频https://www.bilibili.com/video/BV1ZwKVe6EBn

1. 安装Ollama

Ollama 目前提供一键安装包,根据自己的电脑系统下载对应版本 Ollama:

下载完成后自行安装即可。

2. 下载需要的模型

安装完成后启动命令行窗口输入命令下载模型。

注意:很多同学没有用过命令行不知道在哪里启动,统一说一下:MacOS 用户在应用界面搜索打开“终端”(Terminal)应用;Windows 用户打开 PowerShell进行运行。操作非常简单,只需要复制粘贴按回车键,等待模型下载完毕即可。

具体命令可以通过点击官网Models后,搜索并选择所需要的模型后查看。

比如下图我选择 deepseek-r1 的 14b 模型,直接点击按钮即可复制这一行命令:

在命令行中粘贴这一行命令,并按回车键执行,就会自动下载该模型(下载过程需要科学上网),可以看见进度条:

下载完毕之后会自动运行该模型,我们可以尝试在终端中进行提问:

在启动 Ollama 之后,是会在后台运行的,默认端口为 11434,我们可以在浏览器中访问本机端口看一下:http://127.0.0.1:11434

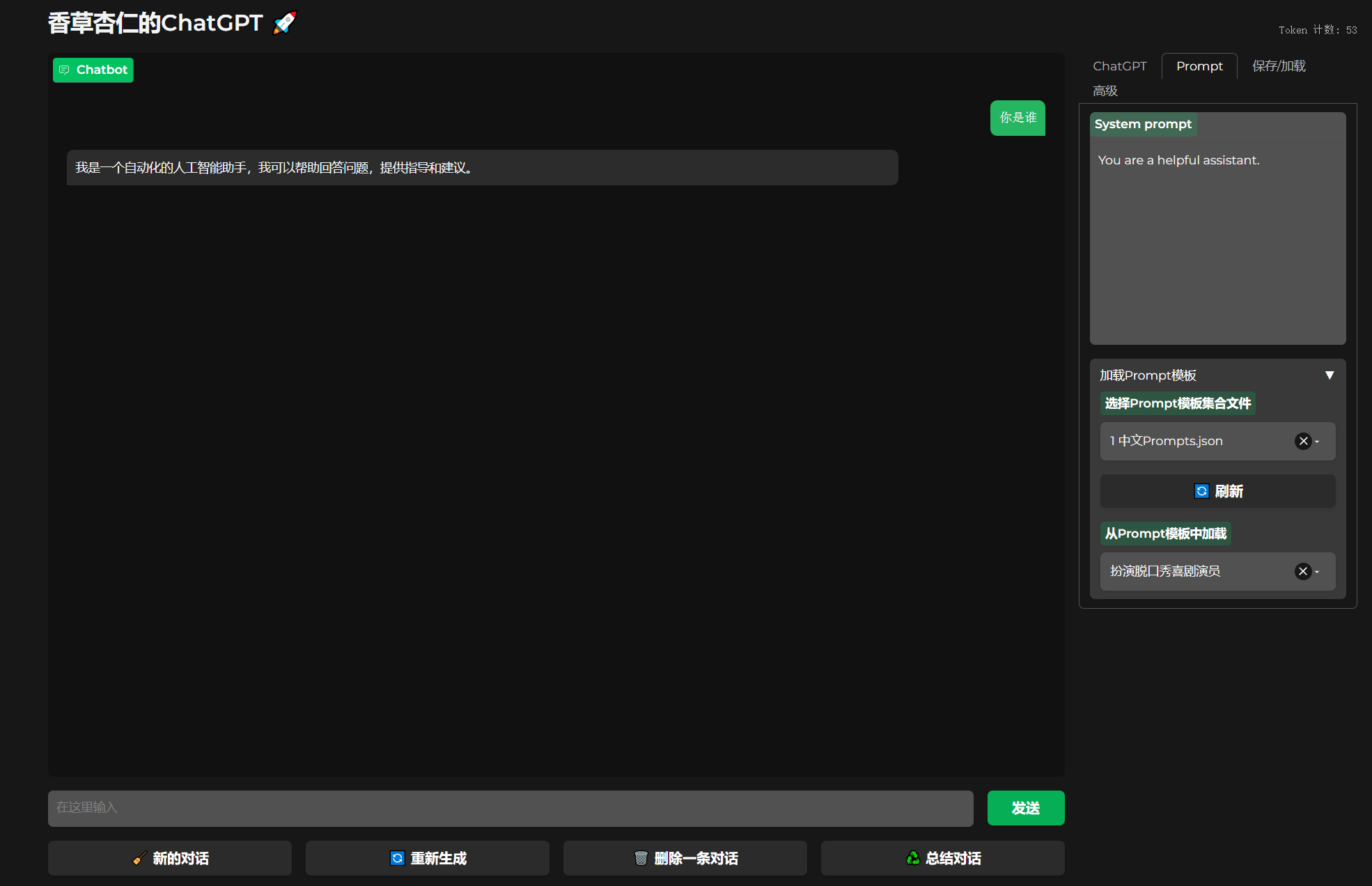

3. 安装并配置AnythingLLM

上面可以看到效果非常不错,但是在终端中使用非常不美观且不方便,我们需要再安装配置一个前端界面。本文选择使用 AnythingLLM 作为前端使用,此软件安装非常简单,不需要使用到 docker,并且构建知识库时非常方便。安装和使用只需要少量计算机知识,对非 IT 领域的科研工作者比较友好。

我们这里直接下载,根据自己电脑系统进行选择:AnythingLLM桌面版

同样的,下载完成后自行安装,首次启动会有安装向导:

选择大模型。如下图所示设置使用Ollama,也就是我们前面下载的本地模型,然后设置参数

- 指定Ollama Base URL为 http://127.0.0.1:11434

- 指定Chat Model Selection为 deepseek-r1:14b

- 指定Token context window为 8192

因为我之前已经安装过了,下面找了网上的图供参考,后续有其他设置选择默认的即可,进入软件之后我们随时都可以修改设置的。知识库名称自行定义即可。

进入软件之后,可以在设置中选择语言、修改模型等等:

我的模型设置如下,供参考:

回到主界面,可以新增、修改、删除工作区,点击上传按钮,可以在工作区中上传文档作为个性化的背景知识(也就是知识库):

添加文档时可以直接将整个文件夹拖动进去进行批量添加,非常方便。然后将需要的文档移动到知识库 2,Save and Embed 即可。

点击 New Workspace 我们可以根据自己的需要创建多个相互隔离的工作区,New Thread 按键可以在当前工作区内添加新对话。

当然,AnythingLLM 除了可以上传本地知识库外,通过 DataConnectors 功能,我们也可以通过 github 仓库进行上传,甚至可以通过爬虫爬取指定网站的全部数据作为知识库(注意版权问题)。这部分功能下次有机会再讨论。

4.知识库效果演示

同样使用 14b 模型,我问一个文献中的问题:resistin 在心血管疾病中的作用研究进展?

知识库 1 (没有上传文档)的回答情况:

知识库 2(有参考文档)的回答情况:

5.扩展一:为本地大模型添加网页搜索功能

首先进入设置,修改以下内容:

有许多搜索引擎可以选择,最简单的就是 DuckDuckGo,选择即可,不需要填写 api 信息,免费使用。

经过尝试,DuckDuckGo效果还可以,当然如果需要更好的效果,更推荐使用 Google 引擎,但是需要申请 api,在下方链接自行申请:Google 搜索控制台

如果需要调用搜索,请在提问时@Agent:

调用搜索背后的逻辑是:通过第三方引擎如 DuckDuckGo 或 Google 进行关键测搜索,本地模型识别并阅读前 n 条结果,将内容进行总结。使用效果如下:

模型思考和回答:

6.扩展二:通过 api 调用 Deepseek

大多数情况下我们个人电脑的配置只能运行蒸馏后(distilled)的小模型(比如 7b 或 14b,好一点的能用 32b),无法发挥 deepseek 的全部潜力,而我们可以用通过调用 api 的形式使用更完整的模型。但是请注意,如果您的隐私需要较高,请优先使用本地模型,因为任何第三方模型都有可能泄露您的对话内容。

deepseek 官方 api

由于 deepseek 目前实在太火,官网的对话功能也经常宕机,官方的 api 目前不太好申请。

groq免费api:70b模型

groq 提供免费的 70b 模型 api,有速率限制。登录和使用 groq 需要科学上网,并且很多国内邮箱无法注册,建议使用谷歌登录。

硅基流动付费api满血:满血 671b 模型

这是目前能够找到的最稳定的满血模型 api,推荐使用,请注意价格。

SiliconFLOW 硅基流动目前有活动,新用户注册时填写邀请码:vCnxCugh 可获得 2000 万 token 的免费额度(折合 14 元 rmb)。

个人使用通常需要考虑费用问题,建议日常简单任务使用本地模型,复杂任务可以临时调用 api 访问满血模型。这在 AnythingLLM 中可以很方便的切换。

参考链接

- Deepseek 官网

- Deepseek 开源项目

- Ollama下载

- AnythingLLM 下载链接

- Google 搜索控制台申请搜索 api

- groq 免费 api

- SiliconFLOW 硅基流动 满血版 R1 模型

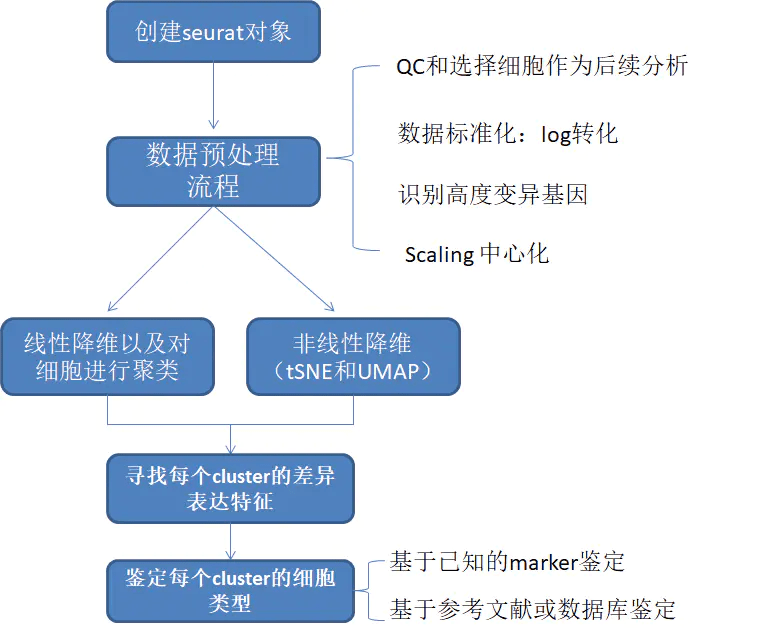

本文介绍了在本地部署Deepseek-R1模型并构建知识库的步骤,主要分为五个部分。首先,用户需要安装Ollama软件,并通过命令行下载所需的模型。接着,通过访问指定的本地端口,可以在浏览器中查看模型的运行情况。然后,用户需要安装并配置AnythingLLM作为前端界面,在设置中输入Ollama的Base URL和选择对应的模型,以便更方便地进行交互。之后,可以通过上传文档来构建个性化的知识库,支持批量添加文件。此外,AnythingLLM提供了通过DataConnectors功能,从Github或特定网站爬取数据的方法。最后,文章展示了如何为本地模型添加网页搜索功能,以增强回答的准确性。总之,该过程为科研工作者提供了一个友好的AI使用体验,便于进行文献研究和信息查询。

暂无评论内容